«Comprendre l'IA est essentiel...» - Entretien exclusif avec Luc Julia, cocréateur de Siri #3

Personnalité emblématique de l'Intelligence Artificielle et auteur du provocateur "L'IA n'existe pas", Luc Julia démystifie les idées reçues sur l'IA en proposant un regard éclairé sur son évolution.

Dans ce nouveau numéro de “IA, Tech & Travel Café”, je vous propose une édition un peu spéciale, dédiée à un entretien exclusif avec Luc Julia (oui, c’est lui derrière “Dis Siri !” 😃). Il nous partage sa vision éclairée sur le déploiement de l’Intelligence Artificielle dans notre quotidien. C’est parti !

«Interdire l'IA serait aussi absurde que d'avoir voulu interdire Internet ou l'encyclopédie Universalis»

Nicolas François : L'intelligence artificielle, un domaine central de votre carrière, se démocratise et devient un enjeu éducatif majeur. Concrètement, comment recommanderiez-vous d'intégrer l'éducation à l'IA dans notre vie quotidienne, ainsi que dans un contexte professionnel ?

Luc Julia : Dès le début, il est essentiel de ne pas mentir ni interdire. Ne pas mentir implique d'expliquer clairement ce qu'est l'IA, ce qu'elle n'est pas, et ses applications potentielles, tout en soulignant les aspects qui fonctionnent et ceux qui ne fonctionnent pas. Par exemple, de nombreuses IA génératives ont des limites. Il est important de noter que l'IA au sens large (pas que l’IA générative) existe depuis 67 ans et a généré de nombreuses idées avec des degrés de succès variés. Et interdire l'IA serait aussi absurde que d'avoir voulu interdire Internet ou l'encyclopédie Universalis. Il faut expliquer, expliquer, expliquer, et surtout illustrer par des exemples et des contre-exemples. Particulièrement pour des technologies comme ChatGPT ou d'autres IA génératives, en montrant que leur pertinence est souvent faible lorsqu'elles sont trop génériques. Dès qu'elles sont spécialisées, elles deviennent plus efficaces. Cependant, tant qu'elles restent génériques, leur fiabilité est limitée et elles peuvent produire de nombreuses erreurs, ce qu'on appelle des hallucinations. Il est donc essentiel de simplement expliquer, montrer et démontrer.

Et dans le milieu professionnel ?

Que ce soit dans le milieu professionnel ou familial, il est essentiel de montrer comment l'IA fonctionne et d'identifier ses limites. Il faut particulièrement démontrer comment l'outil peut être utilisé de manière efficace dans les domaines qui intéressent les gens, car après tout, ce ne sont que des outils, sans aucune magie. Ces outils offrent des avantages sans remplacer les humains; ils servent plutôt à améliorer leur travail. Les patrons rêvent parfois de remplacer le personnel par des IA pour booster la productivité, mais en réalité, les gains de qualité sont souvent plus significatifs que ceux liés à la productivité. Les IA, en somme, ne sont pas là pour nous remplacer...

Concernant la pertinence des IA génératives, les derniers chiffres datent de février 2023 et on parlait alors de seulement 64% de pertinence. J'ai essayé de trouver des chiffres plus récents mais je n'en ai pas trouvé…

C’est normal, il n'y en a pas car c'est extrêmement compliqué. La dernière étude sur ChatGPT 3.5, celle réalisée à Hong Kong en février 2023, n’a pas donné de résultats concluants, malgré l'analyse de 20 millions de données. Or, il est essentiel d’avoir des données statistiquement valides, ce qui prolonge et complique ces études. Un niveau de pertinence de 64% n’est clairement pas satisfaisant, ça veut dire que l’on a 36% d'erreurs… c’est énorme. Obtenir des résultats fiables est donc un processus long et difficile. Le test peut sembler simple – vérifier des faits avérés – mais en réalité, il est difficile à mener correctement et à interpréter.

«L'outil peut être utilisé pour sauver la planète, mais il peut être aussi celui qui participe à la détruire…»

Quels sont les avantages majeurs apportés par l'IA à la société et les dangers potentiels que l'humain peut créer pour l'avenir de l'IA ? Vous utilisez parfois l’image du marteau qui, tout comme l’IA, serait un outil…

Effectivement, l'IA est un outil qui peut être utilisé à bon ou à mauvais escient. C'est exactement ce que sont les IA : des outils qui ne dérogent pas à cette règle. Parfois, un outil peut s'avérer inutile, et si c'est le cas, alors il ne remplit pas sa fonction d'outil. Cependant, il faut être conscient de la différence entre un marteau et les IA, car ces outils d'intelligence artificielle ont un impact beaucoup plus significatif sur la planète. La fabrication d'un marteau nécessite juste un peu de bois pour le manche et un peu de métal pour la tête, avec un impact relativement limité. En comparaison, l'impact des IA est énorme.

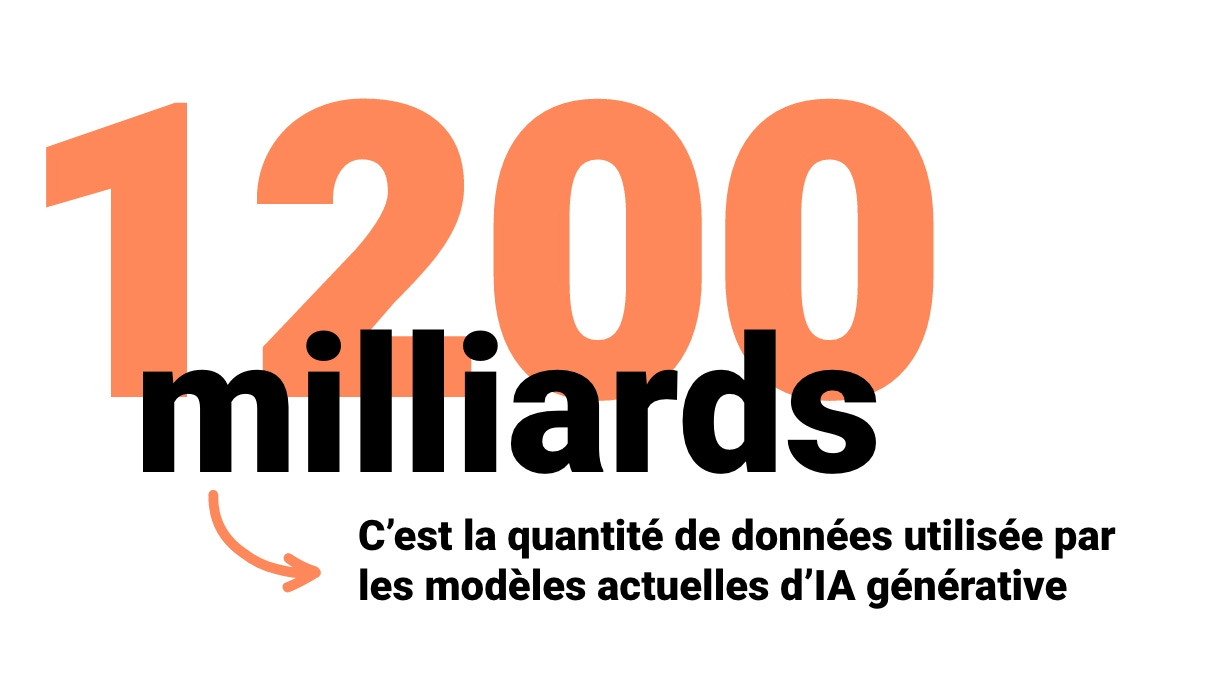

À mesure que les IA évoluent, leur impact augmente également. Les modèles actuels, par exemple, nécessitent des quantités astronomiques de données, jusqu'à 1200 milliards, ce qui exige une énorme quantité d'électricité1 pour les créer. De plus, les dernières générations d'IA génératives nécessitent beaucoup d'électricité non seulement pour la création des modèles mais aussi lors de l'inférence2. Il faut donc faire attention quand on crée un outil, il faut regarder quel est son impact sur l'environnement, sur le monde, pour voir si on n'est pas en train de bousiller la planète au moment où on utilise l'outil. Donc c'est une balance tout ça. L'outil peut être utilisé pour sauver la planète, mais il peut être aussi celui qui participe à la détruire…

Selon vous, existe-il des pistes pour réduire ce besoin exponentiel d’énergie ?

Oui, il existe des pistes intéressantes. Nous n'aborderons pas la décroissance, car ce n'est pas à la mode... Mais dans le domaine des IA, surtout les génératives, au lieu de développer de grands modèles de langage, il serait judicieux de créer des modèles plus petits et spécialisés, adaptés à des domaines spécifiques. Ces modèles seraient plus frugaux en ressources. Il existe aussi d'autres approches, comme redécouvrir les techniques des années 50 et 60, où les IA utilisaient peu d'énergie et étaient basées sur des dialogues ou des statistiques. Nous pourrions réintégrer ces anciennes méthodes et les combiner avec des approches modernes pour optimiser leur efficacité. C'est une piste prometteuse que de faire collaborer ces différentes disciplines mathématiques.

Même si le secteur du voyage peut paraître un peu éloigné du vôtre, avez-vous déjà imaginé des usages où l’IA pourrait améliorer l'expérience touristique ?

En fait, ma première entreprise créée en Californie s’appelait LuxTours, spécialisée dans les visites virtuelles de San Francisco. C'était en 1993/1994, une époque où Internet n'était pas encore très répandu. J'utilisais une cassette audio que les visiteurs mettaient dans leur lecteur. À cette époque, il fallait souvent arrêter ou avancer la cassette manuellement en fonction du trafic, ce qui pouvait être fastidieux. Il n'y avait pas de GPS. C'était amusant, et cela m'a fait apprécier l'utilisation des assistants numériques, puisqu'on n'avait pas toujours des guides physiques à disposition. En 2003/2004, j'ai créé TravelMate, un autre guide qui utilisait le GPS et l'IA pour augmenter l'expérience utilisateur. Cette fois, en regardant un bâtiment, les informations étaient superposées directement via des lunettes de réalité augmentée, montrant quand et par qui le bâtiment avait été construit, entre autres détails.

Aujourd'hui, on voit des technologies similaires dans les musées pour des expositions spécifiques. Tous ces guides, qu'ils soient audio ou virtuels, offrent une liberté bien plus grande que dans un musée traditionnel. Ça serait intéressant de développer davantage cette technologie pour permettre aux gens de comprendre l'histoire complète des bâtiments qu'ils observent. Faire pour de vrai le TravelMate des années 2000… :)

Vous êtes passionné par l’informatique depuis votre plus jeune âge et la légende raconte que vous avez même hacké un Minitel à 12 ans… :) Si vous pouviez donner un conseil au jeune garçon que vous étiez à l'époque, quel serait-il ?

Ah ! Et bien, je pense que j'ai eu de la chance car je me suis tout de suite amusé et je suis tombé dedans au début, pas au début de l'informatique évidemment, mais au début de la micro-informatique. Donc oui, quand cela a commencé à être vraiment accessible à tout le monde, hacker, tester, c'était ce qu'il fallait faire au départ pour comprendre un peu comment cela fonctionnait. Donc j'ai eu de la chance de tomber à ce moment-là. Ce que j'aurais pu faire peut-être de mieux, c'est de me concentrer un peu plus sur la théorie et de faire un peu plus de mathématiques. Ça m'aurait permis de faire… oui, en fait je ne suis même pas sûr, car j'ai fait quand même pas mal de maths depuis dans ma jeunesse (rires)… Mais je pense que c'est les maths en fait la clé, ce n'est pas d'apprendre des langages, parce que les langages s'apprennent tout seul. En fait, c'est même assez simple. Ce qui est moins facile, c'est de développer une certaine logique et de comprendre les notions mathématiques liées aux statistiques et à la logique des algorithmes, ainsi que de savoir comment fonctionnent les ordinateurs. Cela signifie peut-être que, dans les années à venir, il pourrait être intéressant de se pencher également sur la physique. Peut-être que les ordinateurs du futur seront des ordinateurs quantiques3 plutôt que des ordinateurs physiques classiques. Je ne sais pas, cela va prendre un peu de temps… Si un jour ils existent, cela pourrait être intéressant. Donc, il y a peut-être un peu de travail à faire du côté de la physique, mais je pense que les mathématiques restent une valeur sûre.

La question d’actu

J’ai profité de cet échange pour l’interroger sur un sujet d’actualité lié aux dernières annonces d’OpenAI.

Sam Altman, CEO d’OpenAI, s’exprimait récemment sur les évolutions attendues avec GPT-5 et un modèle “plus intelligent” avec des capacités de raisonnement grandement améliorées4. Pour le grand public, on s’y perd un peu et il est difficile de faire la part des choses entre le marketing et la réalité…

Ah oui, et c'est surtout du marketing ! Altman, Musk, ils jouent tous le même jeu, ils sont là pour vendre leur produit. Pour ce qui est de GPT-5, je ne suis pas sûr qu'il verra le jour... on verra bien. C'est compliqué, étant donné que GPT-4 utilise déjà énormément de données. Quelle forme pourrait prendre GPT-5 ? Peut-être quelque chose comme ce que Mistral a fait avec son 8x7, une hybridation de deux LLMs5 où l'un corrige l'autre. GPT-5 pourrait donc ressembler à ça. Mais GPT-4, c'est déjà 1000, disons 1200 milliards de paramètres, pratiquement tout Internet, donc c'est difficile d'aller au-delà. S'ils y parviennent ? Ce n'est selon moi pas du tout certain. Et je suis surpris par les autres déclarations d'Altman qui indiquent qu'ils se concentrent désormais sur les applications... Si un nouveau modèle émerge, il s'agira probablement d'une hybridation entre deux ou trois LLMs, peut-être quatre. Mais pour l’humain, c'est compliqué, car beaucoup d'éléments sont intangibles. Des notions, comme l'amour ou l'empathie, sont difficiles à décrire, sauf peut-être pour les poètes ou ceux qui maîtrisent bien les mots. C'est difficile à modéliser. Donc, pour un modèle doté d'empathie, ou quelque chose de similaire, il va falloir patienter encore un peu.

Merci beaucoup à Luc Julia d’avoir répondu à ces questions et de nous avoir partagé sa vision éclairée sur ce sujet d’actualité.

Qui est Luc Julia ?

Pour ceux qui ne le connaissent pas, le Dr. Luc Julia est une figure emblématique du monde de l'Intelligence Artificielle. Actuellement Directeur Scientifique chez Renault, il a été auparavant Vice-président de l'innovation chez Samsung Electronics avant son passage très remarqué chez Apple pour diriger le projet de l’assistant vocal Siri.

Avec plus de 30 années d'expérience en Intelligence Artificielle et informatique entre la Silicon Valley et l'Europe, il détient de multiples brevets et est l'un des technologues français les plus influents. Il a été fait Chevalier de la Légion d'honneur et est membre de l'Académie Nationale des Technologies.

Auteur reconnu, célèbre pour son livre “L'Intelligence Artificielle n'existe pas”, Luc Julia démystifie les idées reçues sur l'intelligence artificielle, en proposant un regard éclairé sur son évolution et ses implications dans notre quotidien. Il préfère d’ailleurs parler d’intelligence “augmentée” plutôt qu’artificielle.

📖 Je ne peux que vous conseiller la lecture de ce livre qui vous aidera également à mieux comprendre l’histoire de l’IA.

💬 Votre avis m’intéresse !

Vous souhaitez participer à cet échange, apporter votre vision sur ce sujet… n’hésitez pas à intervenir, que ce soit ici sur Substack ou sur Linkedin, Instagram… :)

☕️ Un café… l’addition !

C’est fini pour ce nouveau numéro !

J’espère qu’il vous a plu, n’hésitez pas à me le dire (un pouce, un coeur, un restack, un repost, un message… :) c’est important pour moi d’avoir votre retour 🙏🏻

👋 Rendez-vous le mois prochain :)

— Nicolas

Pour en savoir plus : L'IA peut-elle consommer autant d'électricité qu'un pays comme l'Irlande, comme le suggère un chercheur ? (GEO)

Inférence : On parle d'inférence en IA lorsqu'un modèle d'IA produit des prédictions ou des conclusions. L'entraînement en IA correspond au processus permettant aux modèles d'IA de faire des déductions précises. Source : Cloudflare.com

Pour en savoir plus : Qu'est-ce que l'informatique quantique ? (IBM)

GPT-4 est « plus stupide » que GPT-5, selon Sam Altman - Article publié le 6 mai 2024 sur Fanandroid.com

LLM (Large Language Model) : Les grands modèles de langage (LLM) sont des modèles d'apprentissage automatique capables de comprendre et de générer des textes en langage humain. Ils fonctionnent en analysant des ensembles de données linguistiques massives. Source : Cloudflare.com